当前位置:站长资源库 > 服务器教程 >>

- 最新服务器学习:

nginx自定义日志配置

[Nginx]nginx配置文件http{}里面进行自定义日志配置log_formatmain'$remote_addr-$remote_user[$time_local]"$http_host""$request"''$status$nginx每日生成1个日志文件

[Nginx]定义个变量map$time_iso8601$logdate{ '~^(?<ymd>\d{4}-\d{2}-\d{2})'$ymd; &nginx目录路径重定向

[Nginx]nginx目录路径重定向目录1nginx修改root映射2通过nginxrewrite内部跳转实现访问重定向3nginx设置别名alias映射实现4通过nginx的permanent301绝对跳转实现5通过判断uri实现页面跳转如果希望[Linux] 解决nginx: [emerg] directive

[Nginx]程序员老狼于2019-11-2117:23:00发布阅读量1.8k收藏点赞数版权解决nginx:[emerg]directive\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\fastadmin宝塔bt部署出现后台登录404,前台正常

[Nginx]fastadmin部署出现后台登录404,前台正常部署fastadmin程序的时候后台登录界面404,前台正确http://127.0.0.1/yizuotunet.php自动跳转到http://127.0.0.1/yizuotune.伪静态%{REQUEST_FILENAME} !-f 和!-d用法

[Apache]%{REQUEST_FILENAME}!-f和!-d只对下一条RewriteRule起作用。再往下的RewriteRule不管用。-f表示为文件-d表示为目录!表示非,取反的意思RewriteCond%{REQUES

.htaccess 图片不存在 跳转到默认图片

[Apache]您可以在.htaccess文件的顶部使用mod_rewrite来完成此操作:RewriteEngineOn#Redirect\\\"webp\\\"imagesthatdonotexistto\\\"jpg\\\"RewriteCond.htaccess 设置图片 404的方法

[Apache]问题:.htaccess伪静态需要设置图片404的默认图片答案:RewriteEngineonRewriteCond%{DOCUMENT_ROOT}%{REQUEST_URI}!-fRewriteRule\\\\.(gif|jpe?g|nginx rewrite 正则表达式匹配

[Nginx]大小写匹配~为区分大小写匹配~*为不区分大小写匹配!~和!~*分别为区分大小写不匹配及不区分大小写不匹配文件及目录匹配-f和!-f用来判断是否存在文件-d和linux安装lua_nginx_module模块

[Nginx]1.下载安装LuaJIT2.1(2.0或者2.1都是支持的,官方推荐2.1):http://luajit.org/download.htmlcd/usr/local/srcwgethttp://luajit.org/htaccess下配置跨域的方法

[Apache]允许所有域名跨域HeaderaddAccess-Control-Allow-Origin:*Apache Access-Control-Allow-Origin 跨域设置

[Apache]Apache跨域设置:例如yizuotu.com里面的页面需要跨域请求yizuotu.net里面的资源;那么需要设置yizuotu.net返回的HTML请求里面配置Access-Control-A

最新图片服务器教程:

IIS7下配置跨域设置Access-Control-Allow-Origin

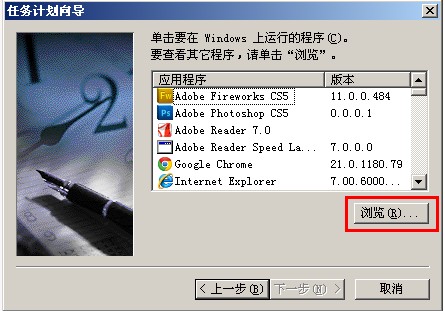

通过系统自带计划任务,实现电脑服务器自动重启设置图文教程

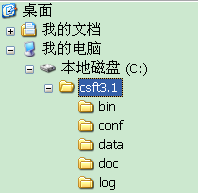

分享Windows下安装Sphinx的方法和步骤

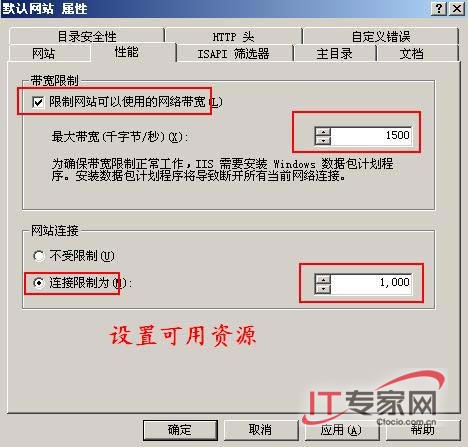

IIS6易做图访问流量的方法以及带宽介绍

让IIS和Apache共同使用80端口的方法

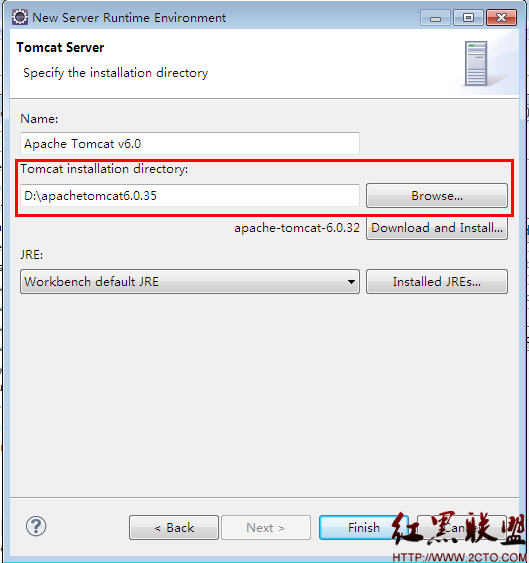

Java EE IDE Eclipse 配置Tomcat

WindowsServer2003R2、IIS6下由于Session会乱串__导致系统无易做图常使用

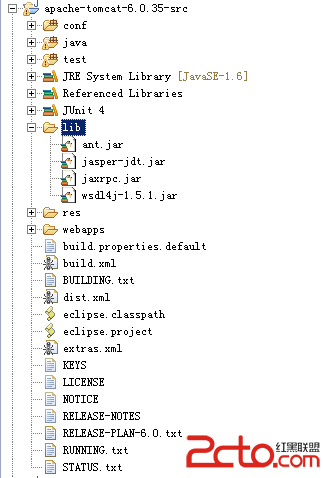

Eclipse导入Tomcat源代码

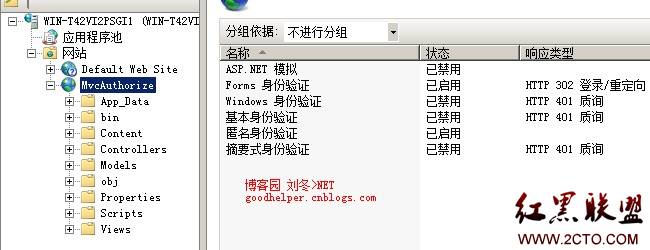

Android与IIS身份验证——Form验证

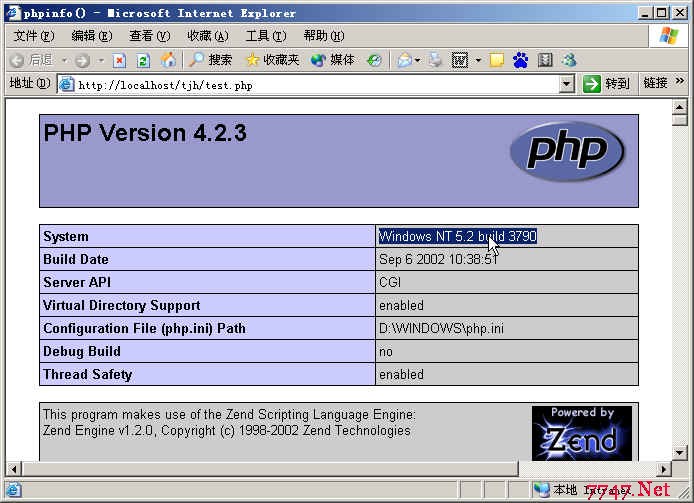

PHP 在Windows 2003 Enterprise Server 、IIS6.0 下的安装

在Windows中安装Apache2和PHP4的权威指南

php-5.3+APACHE 安装配置

- 最新服务器学习信息:

- nginx自定义日志配置

- nginx每日生成1个日志文件

- nginx目录路径重定向

- [Linux] 解决nginx: [emerg] directive

- fastadmin宝塔bt部署出现后台登录404,前台正常

- 伪静态%{REQUEST_FILENAME} !-f 和!-d用法

- .htaccess 图片不存在 跳转到默认图片

- .htaccess 设置图片 404的方法

- nginx rewrite 正则表达式匹配

- linux安装lua_nginx_module模块

- htaccess下配置跨域的方法

- Apache Access-Control-Allow-Origin 跨域设置

- nginx server开启Access-Control-Allow-Credentials

- htaccess 防止盗链,防止目录浏览等10大技巧

- Tomcat\Apache\IIS\Nginx 如何关闭Web服务器目录遍历任意文件访问

- 如果你遇到编程难题:

访问站长资源库:www.zzzyk.com

最近更新:2024-07-16 14:11:01